Les 10 tendances clés de l'IA générative en 2025 et après 2026

1. Vidéo & multimodalité extrême

L’IA générative se tourne désormais vers la multimodalité totale : texte, image, son et surtout vidéo. Des modèles-phares l’illustrent : Sora d’OpenAI, qui crée des séquences 1080p de vingt secondes à partir d’un simple prompt openai.com ; Veo 3 de Google DeepMind, capable d’ajouter dialogues, bruitages et effets visuels photoréalistes nativement deepmind.google ; et l’architecture « Space-Time U-Net » de Lumiere, qui génère l’ensemble d’une vidéo en un seul passage pour garantir la cohérence temporelle.

Ces plateformes transforment un script en narration complète : avatars réalistes, animations synchronisées, musique et voix off. Les usages explosent : e-learning multilingue avec synchronisation labiale, campagnes publicitaires uniques créées en minutes, ou résurrection virtuelle d’acteurs disparus. Microsoft prévoit même la mise à disposition gratuite de Sora dans Bing, ouvrant ces capacités au grand public.

Mais cette révolution s’accompagne de défis : puissance de calcul colossale, biais culturels, deepfakes. Le magazine TIME a déjà alerté sur le potentiel de Veo 3 à produire des vidéos de désinformation hyper-réalistes time.com. Pour y répondre, les leaders mettent en place filigranes invisibles, contrôles de sécurité renforcés et politiques d’usage responsable. Malgré ces enjeux, l’avancée rapide des algorithmes et de l’infrastructure cloud rend l’« extrême multimodalité » inévitable – et prometteuse pour la création de contenus de demain.

2. Agentic AI : agents autonomes

Depuis l’entrée en vigueur de l’AI Act (1ᵉʳ août 2024), l’Union européenne définit un système d’IA comme « une machine capable de fonctionner de façon autonome et adaptative ». Les agents autonomes sont la forme la plus avancée de ces systèmes : ils observent leur environnement, se fixent des sous-objectifs et agissent sans commande humaine directe. Le Stanford AI Index 2024 qualifie cette capacité de « proactivité de bout en bout ».

3 niveaux faciles à retenir

Depuis que l’AI Act européen est entré en vigueur (1ᵉʳ août 2024), un « système d’IA » est officiellement décrit comme une machine capable de fonctionner de façon autonome et adaptative après son déploiement EU AI Act First Regulation. Les agents autonomes représentent le sommet de cette définition : ils observent, décident puis agissent sans qu’on leur tienne la main. Le Stanford AI Index 2024 désigne cette aptitude comme de la « proactivité de bout en bout ».

Trois façons d’utiliser l’IA, en une minute

- Utilisateur GenAI : vous écrivez un prompt, l’IA répond. Exemple : « Résume moi ce livre ».

- Utilisateur Agents IA : vous donnez une petite mission et l’agent enchaîne plusieurs appels d’IA pour la terminer (réserver voyage, compiler un rapport, etc.).

- Utilisateur Agentic : vous confiez un objectif complexe à un essaim d’agents qui planifient, négocient entre eux et apprennent en continu — par exemple lancer un produit de A à Z. Exemple (1ère version - tâches simples et pas infaillible) : https://manus.im / idem https://lovable.dev/

Les quatre briques qui rendent un agent vraiment autonome

- Autonomie : il se fixe ses propres étapes vers la cible.

- Prise de décision : il teste virtuellement plusieurs scénarios puis choisit la meilleure action.

- Apprentissage continu : il se corrige quand arrivent de nouvelles données.

- Interaction : il discute avec vous ou d’autres agents en langage naturel.

Ces critères sont ceux qu’emploie Stanford pour qualifier un agent « pleinement autonome »

Où les rencontre-t-on déjà ?

• Finance : l’ESMA a rappelé en mai 2024 que, même piloté par l’IA, le trading reste sous la responsabilité des dirigeants des banques ESMA guidance AI in investment services.

• Santé : l’OMS recommande plus de 40 garde-fous avant de confier la surveillance de constantes vitales ou l’ajustement d’un traitement à un agent who.int.

• IT : Génération d’un logiciel / application de bout en bout à partir d’un prompt. Exemple: https://lovable.dev

• Mobilité : la norme SAE J3016 décrit les niveaux 3 à 5 où le véhicule gère frein, accélérateur et volant sans remettre la main au conducteur, sauf situation critique sae.org.

• Service client : les chatbots “24 h/24” rédigent un e-mail, déclenchent la logistique et mettent à jour votre dossier — tout cela sous les obligations de transparence imposées par l’AI Act artificialintelligenceact.eu.

À retenir

Un agent autonome n’est pas juste un chatbot « plus malin » : c’est un logiciel qui peut décider, apprendre et agir à votre place. Commencez par des usages GenAI simples, testez un agent sur un petit projet, puis passez au mode agentic pour déléguer des tâches complexes… tout en restant dans les clous de la régulation européenne.

3. Génération on-device (Edge AI) (modèles 7B embarqués)

L’IA embarquée : quand un modèle 7 milliards de paramètres tient dans votre poche

Depuis début 2025, Google rend ses modèles Gemma 7B exécutables dans une simple appli Android via l’API MediaPipe LLM Inference ; la démonstration officielle tourne sur un Pixel 8 sans connexion réseau ai.google.dev. Qualcomm, de son côté, montre un Snapdragon X Elite capable de faire tourner un modèle de plus de 13 milliards de paramètres localement, avec une latence inférieure à 20 ms qualcomm.com.

Pourquoi est-ce une rupture ?

Exécuter le calcul « chez l’utilisateur » réduit le temps de réponse, évite d’envoyer des données sensibles dans le cloud et baisse la facture de bande passante. Un rapport McKinsey estime que le traitement en périphérie peut diviser par trois le coût total d’exploitation d’un service IA grand public.

Ce qu’on peut déjà faire, sans réseau :

- Une voiture peut générer des instructions vocales personnalisées même dans un tunnel.

- Un bracelet médical analyse en temps réel le rythme cardiaque et alerte avant l’arythmie, sans exposer les données du patient.

Meta illustre le potentiel : son modèle Llama 3 8B tourne hors-ligne sur un simple ordinateur portable pour écrire textes ou générer code ai.meta.com.

Sous le capot, la prouesse vient de :

- La quantisation qui comprime les poids du réseau sans trop perdre en précision.

- Des puces spécialisées ; le processeur neuromorphique Loihi 2 d’Intel promet dix fois moins d’énergie qu’un GPU classique pour l’inférence locale intel.com.

- Des techniques de distillation comme LoRA qui rapetissent un grand modèle tout en conservant son savoir.

Le message clé

Grâce aux modèles 7B embarqués, l’IA générative devient aussi mobile que votre smartphone : plus rapide, plus privée et moins dépendante du cloud. Pour les développeurs européens, c’est l’occasion de créer des services conformes à l’AI Act tout en offrant aux utilisateurs une expérience fluide, même hors réseau.

4. Données synthétiques à grande échelle

Les données synthétiques sont des jeux de données fabriqués par des algorithmes plutôt que collectés sur le terrain. Gartner prédit que, d’ici 2026, 75 % des entreprises y auront recours pour entraîner leurs modèles génératifs, contre moins de 5 % en 2023 gartner.comevidence-hub.aetion.com. L’ISO a même publié en 2025 une norme (ISO/IEC 5259-5) qui décrit comment gouverner la qualité de ces « faux » jeux de données iso.org.

Pourquoi tout le monde s’y intéresse ?

- Des volumes XXL à volonté : générer un million d’images de pièces mécaniques ou de radios pulmonaires prend quelques heures, pas des années de prises de vue réelles.

- Plus de variété : on peut créer des scénarios rarissimes — l’accident de la route sous tempête de neige, par exemple — pour rendre un modèle plus robuste.

- Confidentialité intégrée : comme ces données ne correspondent à aucune personne ou entreprise réelle, elles aident à respecter le RGPD et la nouvelle Data Act européenne, qui impose de solides garanties de partage « sans fuite ».

Où les voit-on déjà ?

Dans l’auto-école des voitures autonomes (scènes urbaines inventées), dans la finance (faux portefeuilles client pour tester les algos) ou encore dans la santé, où l’OMS encourage leur usage pour entraîner des IA tout en préservant la vie privée des patients.

Les données synthétiques ouvrent la porte à une IA plus rapide, moins chère et plus respectueuse de la vie privée. Mais pour qu’elles tiennent leurs promesses, il faut des standards de qualité et des audits rigoureux.

5. RAG & LLMOps (modèle locaux) pour l’entreprise

L’essor de l’intelligence artificielle générative a conduit à l’intégration accrue des systèmes RAG (Retrieval-Augmented Generation) et des pratiques LLMOps (Large Language Model Operations) dans les entreprises. Ces technologies permettent de tirer parti des modèles de langage à grande échelle (LLM) tout en y ajoutant une couche d’efficacité organisationnelle et opérationnelle. Leur adoption vise à améliorer tant la gestion des connaissances internes que l’expérience client.

Utilisation du RAG pour la gestion d’informations

Les systèmes RAG combinent les capacités de génération textuelle des LLM avec des bases de données ou des ensembles d’informations externes. Cette association rend possible la production de réponses précises et contextuelles tout en réduisant le risque de “hallucinations”, un problème courant des grands modèles de langage. Dans un contexte d’entreprise, cela permet de :

- Accéder rapidement à des informations pertinentes dans des bases de données internes volumineuses.

- Générer des rapports ou des synthèses adaptées aux besoins spécifiques des services.

- Automatiser les interactions clients avec des assistants virtuels enrichis.

Ces systèmes, particulièrement utiles dans des secteurs tels que la finance, la santé ou le juridique, optimisent le temps et améliorent la fiabilité des réponses générées.

LLMOps : vers une intégration industrielle des LLM

Les pratiques LLMOps, à l’instar du DevOps pour les logiciels traditionnels, offrent un cadre structuré pour déployer et gérer des LLM en production. Les entreprises peuvent ainsi bénéficier de :

- Surveillance continue des modèles pour détecter et corriger les dérives.

- Mises à jour efficaces des données d’apprentissage.

- Optimisation des infrastructures pour réduire les coûts associés au calcul intensif.

En combinant RAG et LLMOps, les organisations peuvent exploiter des flux de travail automatisés tout en garantissant qualité, sécurité et conformité réglementaire. Ces approches collaboratives marquent un tournant dans l’utilisation pratique de l’IA dans l’entreprise moderne.

6. Course open source vs. modèles propriétaires

Depuis quelques années, l’intelligence artificielle générative a fait des bonds de géant. Et aujourd’hui, une question revient partout : faut-il choisir entre des modèles open source (libres et personnalisables) et des IA propriétaires développées par des géants comme OpenAI ou Google ? En 2025, la réponse n’est plus aussi simple.

Des modèles open source de plus en plus puissants

Les IA open source comme Llama 3, Mistral ou DeepSeek ne sont plus de simples alternatives : elles rivalisent sérieusement avec les meilleurs modèles du marché.

- Elles sont gratuites ou très peu coûteuses.

- Elles tournent sur des serveurs classiques, voire des PC haut de gamme.

- Elles peuvent être personnalisées à volonté et intégrées directement dans les systèmes internes d’une entreprise.

👉 Résultat : les startups, chercheurs, écoles et PME les adoptent en masse.

Mais tout n’est pas parfait : il faut les héberger soi-même, savoir les configurer, les sécuriser… Bref, plus de liberté mais aussi plus de responsabilité.

Les IA propriétaires restent très en avance sur certains points

Face à cette vague open source, les grands noms comme OpenAI (ChatGPT), Google (Gemini) ou Anthropic (Claude) misent sur des IA hyper performantes, très bien intégrées dans les outils pro, et faciles à utiliser dès le premier jour.

Leur force ?

- Une grande stabilité et des performances souvent supérieures pour les usages complexes.

- Une prise en charge du multimodal : texte, image, audio, vidéo…

- Une intégration directe avec les logiciels pros comme Microsoft Office, Salesforce, Notion…

👉 Mais cette efficacité a un prix : ces modèles sont plus chers et totalement fermés (on ne sait pas comment ils ont été entraînés, ni avec quelles données).

Aujourd’hui, la tendance est claire : la majorité des entreprises combinent les deux approches.

Les modèles open source sont utilisés pour réduire les coûts, protéger les données

On parle d’architecture hybride : utiliser le bon modèle, au bon moment, selon le besoin.

Et demain ?

D’ici 2026, le paysage va encore évoluer :

- Les IA open source seront encore plus puissantes et faciles à utiliser, grâce à de nouveaux outils communautaires.

- Les IA propriétaires intégreront de plus en plus de fonctions intelligentes en temps réel, comme la voix ou la vision.

- Et avec les nouvelles lois européennes sur l’IA, même les modèles open source devront montrer patte blanche : sécurité, transparence, respect des données…

7. Efficacité énergétique & Green AI (Green IT)

L’intelligence artificielle n’est pas seulement une révolution technologique : c’est aussi un défi énergétique de taille. À mesure que les modèles deviennent plus gros, plus puissants et plus utilisés, leur consommation d’énergie explose. En 2025, former un grand modèle de langage, comme ceux de la génération GPT-4 ou Llama 3, revient à faire voler des dizaines d’avions long-courriers. À titre d’exemple, l’entraînement de GPT-3 aurait généré plus de 550 tonnes de CO₂ — soit l’équivalent d’environ 125 allers-retours entre New York et Pékin.

Et ce n’est qu’un début : d’après le laboratoire national de Berkeley, les data centers américains pourraient consommer jusqu’à 12 % de l’électricité du pays d’ici 2028, contre environ 4 % aujourd’hui.

Pourquoi l’IA consomme-t-elle autant ?

Il faut distinguer deux grands postes de dépense énergétique.

D’un côté, l’entraînement des modèles : ce processus mobilise des milliers de processeurs graphiques (GPU) pendant plusieurs semaines, voire des mois. Il demande une quantité d’énergie colossale, ainsi que des infrastructures de refroidissement intensives.

De l’autre, l’inférence : c’est-à-dire les milliards de requêtes quotidiennes effectuées par les utilisateurs lorsqu’ils utilisent ChatGPT, Gemini ou tout autre assistant. Cela implique une consommation constante, 24h/24, avec des pics de charge importants.

À cela s’ajoutent les infrastructures elles-mêmes. De nouveaux centres de données doivent être construits, parfois dans des zones déjà sous tension électrique, ce qui provoque des retards, des surcharges locales et des tensions politiques.

De vraies avancées matérielles

Face à ce constat, les fabricants de puces ont réagi. NVIDIA, par exemple, promet avec sa nouvelle génération Blackwell une efficacité jusqu’à 25 fois supérieure pour certaines tâches de génération de texte.

Trois leviers pour une IA plus verte

Le premier levier, c’est la conception de modèles plus sobres. Grâce à des techniques comme la quantification, la réduction de précision ou l’exécution par « experts », il est possible de diviser la consommation sans perdre en qualité de réponse. Certains modèles open source comme Mistral ou Qwen montrent qu’on peut atteindre d’excellentes performances avec beaucoup moins de ressources.

Le deuxième levier, c’est l’utilisation d’énergies renouvelables. De nombreux acteurs du cloud, comme Google, Microsoft ou AWS, s’engagent à alimenter leurs centres de données à 100 % avec de l’énergie solaire, éolienne ou hydraulique. Cela ne résout pas tout, mais permet de limiter l’impact carbone direct.

Le troisième levier, c’est la transparence. De plus en plus d’acteurs publient désormais des indicateurs d’empreinte carbone par requête, et orientent automatiquement le traitement vers les régions où l’électricité est la moins carbonée. Cette logique de « routage vert » est encore émergente, mais elle pourrait devenir un standard dans les mois qui viennent.

Ce qui nous attend d’ici 2026

La feuille de route est déjà visible : à court terme, on s’attend à voir se généraliser des formats ultra-compressés de modèles, comme les versions 4-bit. Les data centers vont aussi adopter massivement le refroidissement liquide et les architectures cloud-native plus sobres.

D’ici un à deux ans, les plateformes devraient intégrer des systèmes de routage énergétique en temps réel, pour optimiser les traitements en fonction de l’origine de l’électricité. Et dans les marchés publics comme dans les grandes entreprises, des audits carbone et des critères ESG liés à l’IA deviendront la norme.

8. Régulation & licences IP (Propriété Intellectuelle)

L’évolution rapide de l’intelligence artificielle générative pousse les décideurs, les entreprises et les entités juridiques à repenser les cadres de régulation et les politiques de propriété intellectuelle. En 2025 et après, la réglementation des technologies d’IA devient essentielle pour éviter les dérives éthiques, sécuritaires et juridiques liées à leur adoption généralisée.

Points clés de la régulation de l’IA générative

- Protection des droits d’auteur : Les modèles d’IA générative, en s’appuyant sur des bases de données massives, utilisent souvent des œuvres protégées par le droit d’auteur. Les gouvernements et les organismes internationaux renforcent la législation sur l’utilisation équitable et proposent des solutions pour rémunérer les créateurs originaux.

- Responsabilité et transparence : Les modèles d’IA doivent être conçus pour être transparents et explicables. La régulation pousse les fournisseurs de solutions IA à clarifier comment les données sont utilisées et intégrées dans les modèles, tout en responsabilisant les acteurs face à d’éventuels biais ou contenus préjudiciables.

- Confidentialité des données : Alors que les systèmes d’IA générative manipulent d’énormes volumes de données, la gestion de la vie privée devient primordiale. Des normes strictes sont formulées pour garantir que les informations personnelles ne soient ni stockées ni utilisées de manière abusive.

Licences de propriété intellectuelle

Les licences IP subissent des transformations majeures pour s’adapter aux spécificités de l’IA générative. Trois approches principales se dessinent :

- Licences non exclusives : Les détenteurs de modèles génèrent des profits via des abonnements ou des licences d’utilisation, tout en s’assurant que les créateurs originaux reçoivent leur part légale.

- Licences ouvertes : Certaines organisations plaident pour des licences ouvertes afin de faciliter l’innovation et la collaboration tout en encadrant leurs utilisations pour éviter les abus éthiques.

- Régimes distinctifs pour contenus générés : Des discussions émergent sur la manière de protéger les droits liés aux contenus créés par les algorithmes afin de clarifier la propriété et les droits créatifs.

Les tensions entre innovation et régulation continuent de croître, imposant aux gouvernements et entreprises de trouver un équilibre nécessaire pour canaliser les bénéfices de l’IA tout en évitant les risques inhérents. Des régulateurs internationaux, tels que l’Union européenne, sont déjà en train de poser des bases solides pour une gouvernance coordonnée dans ce domaine complexe.

9. Compression, petits modèles hybrides & spécialisation verticale

Les évolutions de l’IA générative en 2025 et après 2026 soulignent une tendance vers la compression des modèles et l’émergence de solutions hybrides, spécifiquement adaptées à des cas d’utilisation verticaux. Ces développements visent à répondre aux contraintes de puissance de calcul tout en offrant une précision et une pertinence accrues dans les applications ciblées.

Compression et efficacité des modèles

L’une des préoccupations majeures dans l’industrie de l’IA est la taille et les besoins en ressources des modèles. Les modèles géants comme GPT-4 ou ses successeurs consomment d’énormes quantités d’énergie et nécessitent des infrastructures coûteuses. En conséquence, des techniques de compression, telles que la quantification, le pruning (élagage) ou encore la distillation de connaissances, gagnent du terrain. Ces méthodes permettent de réduire significativement le poids des modèles tout en préservant leur performance sur des tâches spécifiques, rendant ainsi l’IA accessible à un plus large éventail d’entreprises et de développeurs.

Modèles hybrides : l’équilibre entre taille et spécialisation

Parallèlement, les modèles hybrides combinant des approches plus petites et spécialisées à des composantes généralistes font leur apparition. Ces modèles, souvent modulaires, répondent à des besoins variés en s’appuyant à la fois sur des capacités génériques et sur des modules spécifiquement entraînés pour des industries ou des domaines spécifiques, tels que la santé, le droit ou la finance. Une telle hybridation optimise l’allocation des ressources computationnelles tout en évitant de perdre la polyvalence des grands modèles.

Spécialisation verticale : un futur d’applications ciblées

L’IA générative tend également vers des solutions spécialisées par secteur, où les modèles sont développés pour exceller dans des niches précises. Par exemple, des IA adaptées aux diagnostics médicaux ou à l’automatisation des assurances remplacent progressivement les solutions généralistes moins performantes dans ces contextes. Cette spécialisation verticale améliore non seulement les résultats, mais renforce aussi la confiance dans les systèmes déployés grâce à leur exactitude dans des domaines critiques.

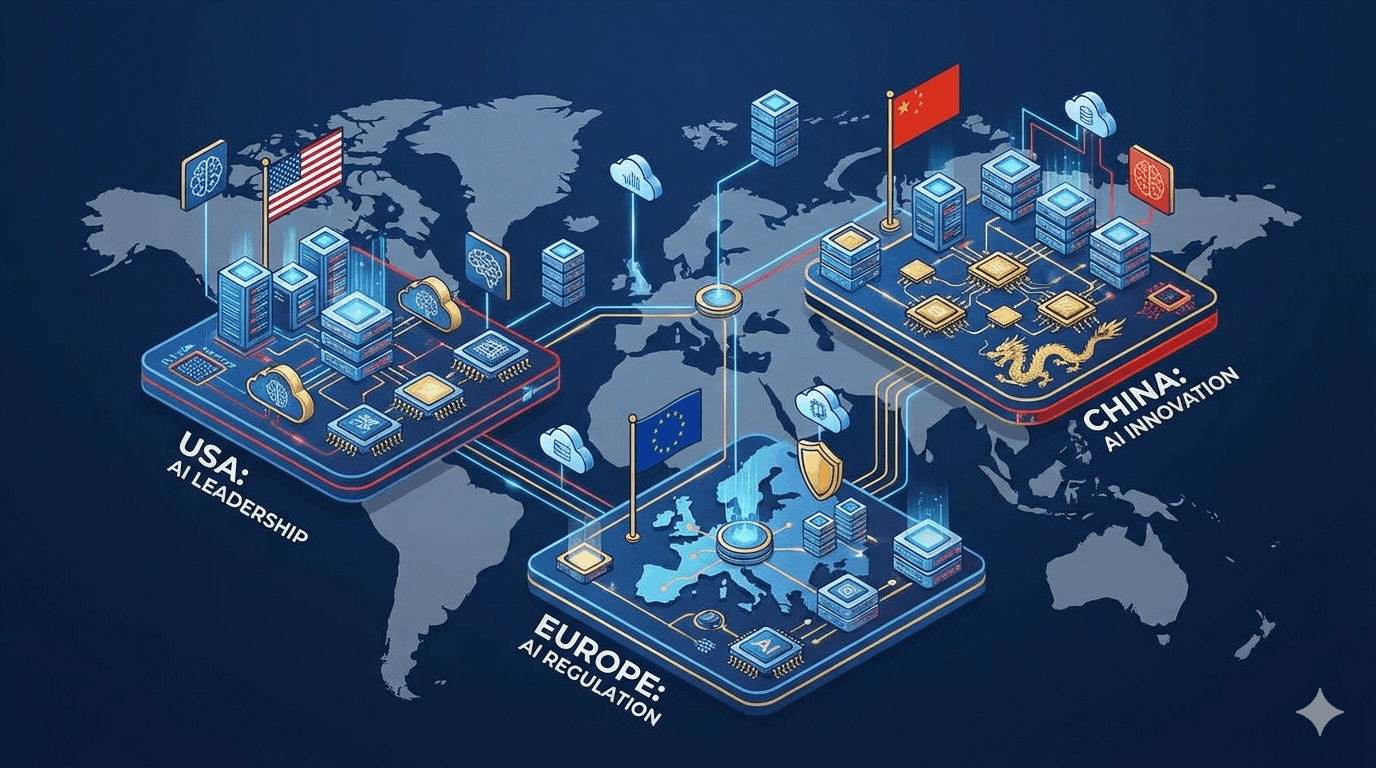

10. Géo-dépendances & instabilité (chips, énergie, régulations, marchés)

L’IA générative européenne repose encore sur des briques – puces, énergie, règles du jeu – décidées loin de Bruxelles. Cet « effet domino » géopolitique peut bloquer un projet du jour au lendemain ; mieux vaut donc connaître chaque maillon fragile… et ses parades.

1. La pénurie de GPU.

Washington limite toujours l’exportation des puces Nvidia H100/H200 vers certains pays. Le fondeur en est réduit à fabriquer des versions « light » (H20) pour contourner l’interdiction reuters.com. Pour ne pas se retrouver sans cartes, les acteurs européens réservent des quotas sur des clusters mutualisés, testent les IPU de feu-Graphcore (désormais aux mains de SoftBank) et suivent de près le processeur Rhea de SiPearl, financé par l’UE pour équiper les futurs supercalculateurs européens eurohpc-ju.europa.eu.

2. Le « risque Taiwan ».

La majorité des puces IA naissent encore chez TSMC. Même si le fondeur a lancé son usine de Dresde, la production (16–28 nm, surtout pour l’automobile) ne démarrera qu’en 2027. Le Chips Act, avec ses 43 milliards €, vise justement à réserver des wafers « Made in EU », mais n’élimine pas la dépendance aux nœuds les plus avancés (3 nm et moins) digital-strategy.ec.europa.eu.

3. ASML sous pression croisée.

Le seul fabricant mondial de scanners EUV est… néerlandais. Les nouvelles règles d’export américaines et néerlandaises interdisent certaines machines aux clients jugés sensibles, ce qui fragilise la chaîne, y compris pour les clients européens asml.com. D’où l’intérêt d’un front commun Bruxelles-La Haye pour clarifier ce qui peut (ou non) sortir du continent.

4. Énergie et réseau sous tension.

Le black-out ibérique du 28 avril 2025 a rappelé qu’un seul incident peut priver des data centers de courant pendant des heures. En toile de fond, la transition verte coûte plus cher que prévu et les réseaux manquent d’investissements. Solution : sécuriser des contrats d’électricité renouvelable longue durée (PPA) et installer des micro-grids ou batteries pour lisser les pics.

5. Régulations qui s’entre-choquent.

L’AI Act européen impose documentation et tests d’impact avant le déploiement de modèles à haut risque. En face, la Chine a déjà ses propres règles – obligation d’« étiqueter » tout contenu généré – qui diffèrent largement des standards occidentaux whitecase.com. Les projets globaux devront donc prévoir, dès la conception, plusieurs « modes compliance » activables pays par pays.

Que faire concrètement ?

Créez dès maintenant une cellule de veille géopolitique : elle scrute export-controls, quotas GPU, prix spot de l’électricité et nouvelles lois IA. Donnez-lui un pouvoir de négociation sur les deux ressources vitales de 2025 – l’énergie verte et les GPU – afin d’assurer vos entrainements modèles même quand la géopolitique s’emballe. Consultez cet excellent rapport du Cigref sur Géopolitique et IT.

Conclusion : Réflexions sur l’avenir de l’IA générative après 2026

L’IA générative de 2025 n’est plus une promesse : elle tourne déjà sur nos smartphones, écrit des vidéos à la volée, négocie des contrats et façonne des jeux de données entiers. Mais cette puissance technique s’accompagne de nouvelles dépendances — puces, énergie, cadres légaux — qu’une entreprise européenne ne peut ignorer.

Pour tirer parti des dix tendances technologiques tout en déjouant le risque géopolitique (#10), trois priorités émergent :

- Industrialiser vite, mais proprement : standardiser un socle RAG + LLMOps, réduire les coûts carbone et documenter les modèles comme l’exige l’AI Act.

- Expérimenter en continu : tester des alternatives open source ou on-device, benchmarker les solutions, tester les nouveaux produits.

- Développer une pensée globale systémique (technologique, humaine, politique, écologique …) comprendre que l’IA n’est pas magique mais repose sur une variété d’acteurs, de technologies et de ressources.

- Construire une veille “360°” permanente : suivre les contrôles exports, l’évolution des normes ISO sur les données synthétiques, les percées hardware en Europe et la fuite éventuelle des talents.

Les organisations capables de conjuguer innovation rapide et vigilance stratégique consolideront un avantage bien plus durable que de simples “prompt hacks”. L’heure n’est plus au POC isolé : c’est le moment d’orchestrer des agents, des mini-modèles, des données synthétiques et des pratiques responsables dans une même feuille de route. À vous de jouer pour transformer ces tendances en produits sûrs, souverains… et utiles à tous.

FAQ

Qu’est-ce que la « multimodalité extrême » en IA générative ?

Les modèles comme Sora ou Veo 3 produisent des contenus mêlant texte, images, audio et vidéo à partir de simples prompts, permettant une création automatisée et cohérente de scénarios digitaux.

Que change l’AI Act pour les entreprises utilisant l’IA générative ?

L’AI Act impose aux entreprises européennes des règles strictes : transparence, auditabilité, documentation et sécurité des systèmes d’IA, quel que soit le fournisseur choisi.