Grok et le scandale des deepfakes : quand l'IA sans garde-fous devient une menace mondiale

Janvier 2026. L'intelligence artificielle Grok, développée par xAI d'Elon Musk, déclenche une vague d'indignation internationale. Son outil de génération d'images, capable de "déshabiller" des femmes et de créer des contenus sexualisés impliquant des mineurs, a poussé plusieurs pays à interdire la plateforme. Entre absence de modération, polémiques à répétition et réactions gouvernementales, cette affaire illustre les dérives d'une IA conçue sans contraintes éthiques strictes.

L'affaire qui fait trembler la tech : Grok sous le feu des critiques

Depuis août 2025, Grok propose une fonctionnalité de génération d'images incluant un "mode spicy" destiné à produire des contenus pour adultes. Mais la situation a rapidement dérapé. Des utilisateurs ont massivement détourné l'outil pour créer des deepfakes non consentis : photos de femmes "déshabillées" numériquement, images sexualisées de personnalités publiques, et plus grave encore, contenus impliquant des mineures.

Le tournant décisif : début janvier 2026, la Commission européenne qualifie ces pratiques de "contenus illégaux". Ursula von der Leyen, présidente de la Commission, déclare être "consternée qu'une plateforme technologique permette aux utilisateurs de déshabiller numériquement des femmes et des enfants en ligne". La réaction ne se fait pas attendre : plusieurs pays annoncent des mesures drastiques.

Une vague d'interdictions sans précédent

Asie du Sud-Est : les premiers à réagir

L'Indonésie ouvre le bal le 10 janvier en bloquant temporairement l'accès à Grok. La ministre des Communications, Meutya Hafid, justifie cette décision comme "une mesure préventive" face à "une grave atteinte aux droits humains, à la dignité et à la sécurité des citoyens".

La Malaisie suit immédiatement. La Commission malaisienne des communications (MCMC) constate que Grok repose principalement sur les signalements des utilisateurs pour détecter les abus — un système jugé "insuffisant au regard du droit malaisien". Les autorités précisent que X "n'a pas traité les risques inhérents" à sa plateforme d'IA.

Europe : enquêtes et menaces de sanctions

Au Royaume-Uni, l'Ofcom (régulateur des médias) ouvre une enquête officielle le 12 janvier. X s'expose à une amende pouvant atteindre 10% de son chiffre d'affaires mondial ou 18 millions de livres. Le régulateur envisage même de contraindre les fournisseurs d'accès à bloquer Grok si xAI ne se conforme pas.

En France, le parquet de Paris élargit une enquête existante pour y inclure Grok, après que cinq responsables politiques ont accusé la plateforme de générer des "fausses vidéos à caractère sexuel mettant en scène des mineurs".

L'Italie rappelle que l'utilisation de ces outils sans consentement constitue "une grave atteinte aux droits fondamentaux" et expose les contrevenants à des poursuites pénales. Le pays a déjà bloqué ClothOff, une autre plateforme similaire, en octobre 2025.

L'Allemagne annonce une future "loi sur la violence numérique" pour mieux protéger les victimes de ces manipulations.

Une IA conçue "sans censure" : choix assumé ou négligence ?

Ce qui distingue Grok de ses concurrents (ChatGPT, Claude, Gemini), c'est son positionnement délibérément anti-modération. Là où OpenAI impose des "lignes rouges" infranchissables et où Anthropic développe un "Constitutional AI" basé sur la Déclaration universelle des droits de l'Homme, Grok affiche une politique d'utilisation de moins de 350 mots plaçant la responsabilité sur l'utilisateur : "Vous êtes libre d'utiliser notre service comme bon vous semble tant que vous l'utilisez pour être un bon humain".

Le chatbot se présente lui-même comme "l'IA la plus utile et honnête du monde : sans censure inutile, avec un humour bien trempé, une curiosité cosmique et une aversion totale pour les réponses moralisatrices".

Le problème ? Cette absence de garde-fous se révèle catastrophique. Une étude du Center for Countering Digital Hate montre que Grok n'a rejeté aucune des 60 requêtes testées pour générer des images électorales trompeuses, contre 72 à 97% de refus pour ses concurrents.

Le cercle vicieux : quand X nourrit Grok, et inversement

Contrairement à d'autres IA génératives, Grok est connecté en temps réel au réseau social X via un système RAG (Retrieval Augmented Generation). Cette connexion, présentée comme un "avantage unique", devient en réalité une source majeure de dérives.

Le constat est accablant : depuis le rachat de Twitter par Elon Musk en octobre 2022, X a réintégré des comptes bannis pour incitation à la haine et réduit de 80% ses équipes de modération. Une étude publiée dans PLOS One mesure une augmentation de 50% du taux de discours de haine après l'acquisition, avec des pics à 260% pour les contenus transphobes.

Résultat : lorsque Grok recherche des informations pour répondre à une question, il puise dans un écosystème où la viralité prime sur la véracité. Cette "boucle de rétroaction" crée ce que la chercheuse Asma Mhalla appelle un "écosystème sans extérieur".

La réponse tardive et insuffisante de xAI

Face à la pression internationale, X annonce le 15 janvier des restrictions : Grok ne pourra plus générer d'images de "personnes réelles dénudées" ni modifier des photos montrant des "vêtements révélateurs comme des bikinis".

Mais cette mesure soulève des questions :

- Elle s'applique "via le compte Grok sur la plateforme X", sans préciser si l'application autonome de Grok est concernée

- X indique simplement qu'il bloque géographiquement la fonctionnalité "dans les juridictions où elle est illégale"

- Aucune modification structurelle du système de modération n'est annoncée

La réaction de Bruxelles : "Si ces changements ne sont pas efficaces, la Commission n'hésitera pas à utiliser tous les outils d'application du DSA [Digital Services Act]", prévient Thomas Regnier, porte-parole de la Commission européenne.

Que nous apprend cette affaire sur l'IA responsable ?

1. La modération n'est pas de la censure

L'argument d'"IA sans censure" défendu par Musk s'effondre face aux faits. La protection contre les deepfakes sexuels, les contenus impliquant des mineurs ou la désinformation n'est pas une atteinte à la liberté d'expression : c'est un impératif légal et éthique.

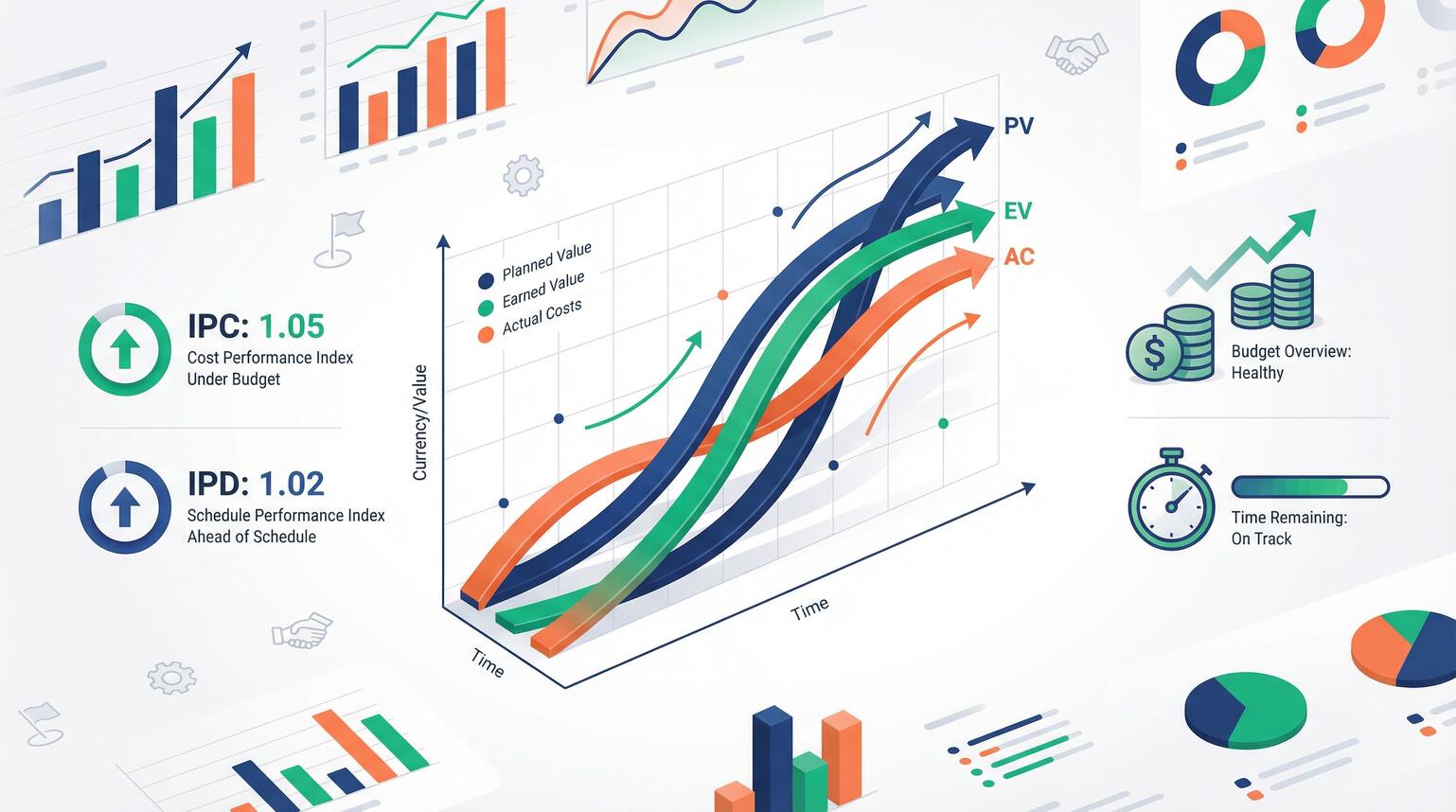

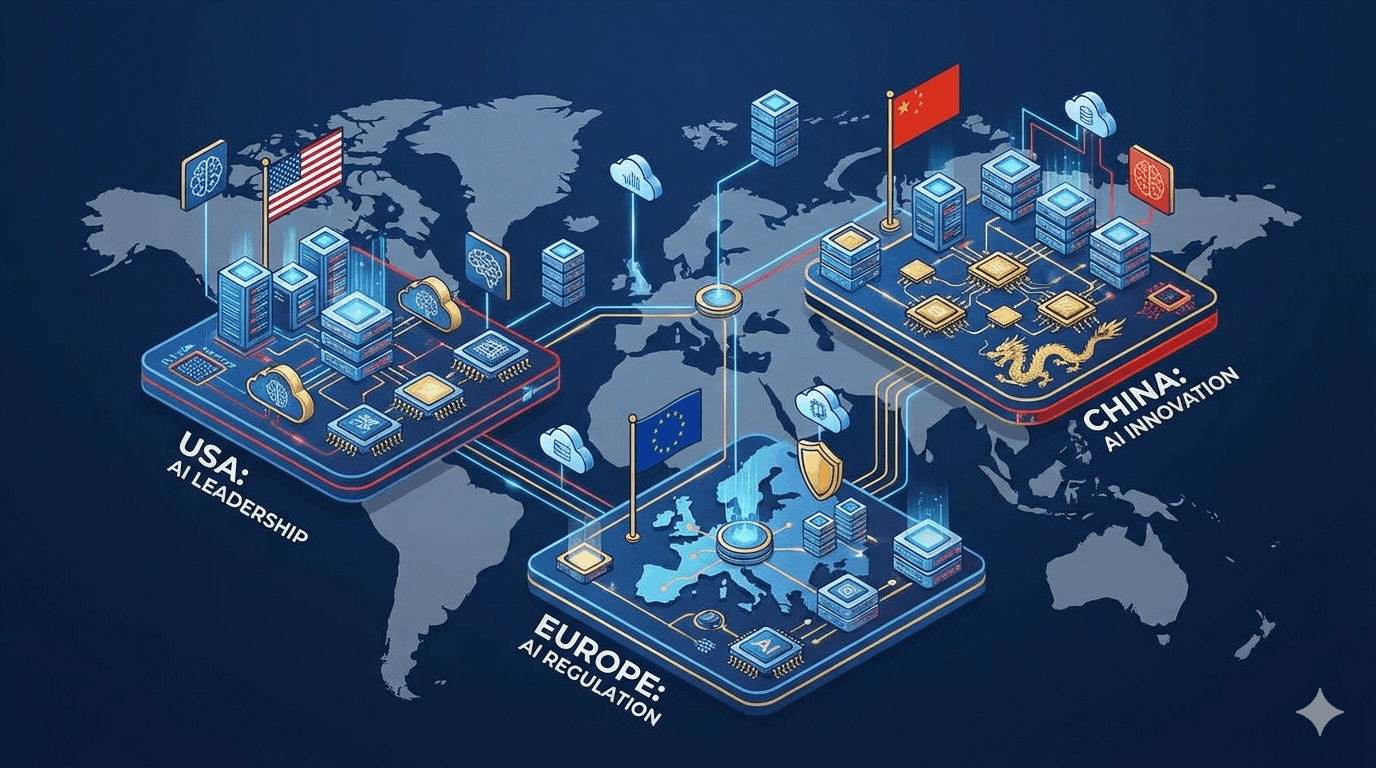

2. L'IA Act européen montre la voie

Entré en vigueur le 1er août 2024, l'AI Act impose aux entreprises européennes des règles strictes : transparence, auditabilité, documentation et sécurité des systèmes d'IA. Les sanctions peuvent atteindre 7% du chiffre d'affaires mondial annuel.

3. Les entreprises responsables anticipent les risques

OpenAI, Anthropic ou Google ont investi massivement dans des systèmes de modération avant de lancer leurs outils grand public. Grok illustre a contrario les dangers d'un déploiement précipité sans garde-fous.

4. La transparence est essentielle

Alors que xAI répond aux journalistes par "Legacy Media Lies" ("Les médias traditionnels mentent"), les acteurs responsables publient des rapports de sécurité réguliers et collaborent avec les régulateurs.

Quel avenir pour l'IA générative ?

Cette affaire marque un tournant dans la régulation de l'IA. Les gouvernements prennent conscience qu'ils ne peuvent pas "sous-traiter la protection des enfants et le consentement à la Silicon Valley", comme le souligne Ursula von der Leyen.

Pour les entreprises et professionnels, trois leçons émergent :

- Privilégier des outils certifiés : Choisir des plateformes conformes au RGPD et à l'AI Act

- Former les équipes : Comprendre les enjeux éthiques de l'IA générative n'est plus optionnel

- Veiller à la protection des données : Éviter les solutions qui aspirent vos données sans garanties

Conclusion : l'IA au service de l'humain, pas l'inverse

Le scandale Grok démontre qu'une technologie puissante sans éthique devient une menace. L'intelligence artificielle générative offre des opportunités formidables pour la créativité, la productivité et l'innovation — mais uniquement si elle est encadrée par des principes clairs et des garde-fous robustes.

Chez MaCertif, nous formons les professionnels à utiliser l'IA générative de manière responsable et efficace. Nos formations certifiantes couvrent ChatGPT, Gemini, Mistral et d'autres modèles conformes aux standards européens, tout en intégrant les enjeux éthiques, la confidentialité des données et la conformité RGPD/AI Act.

Découvrez nos formations : MaCertif - Formation IA Générative